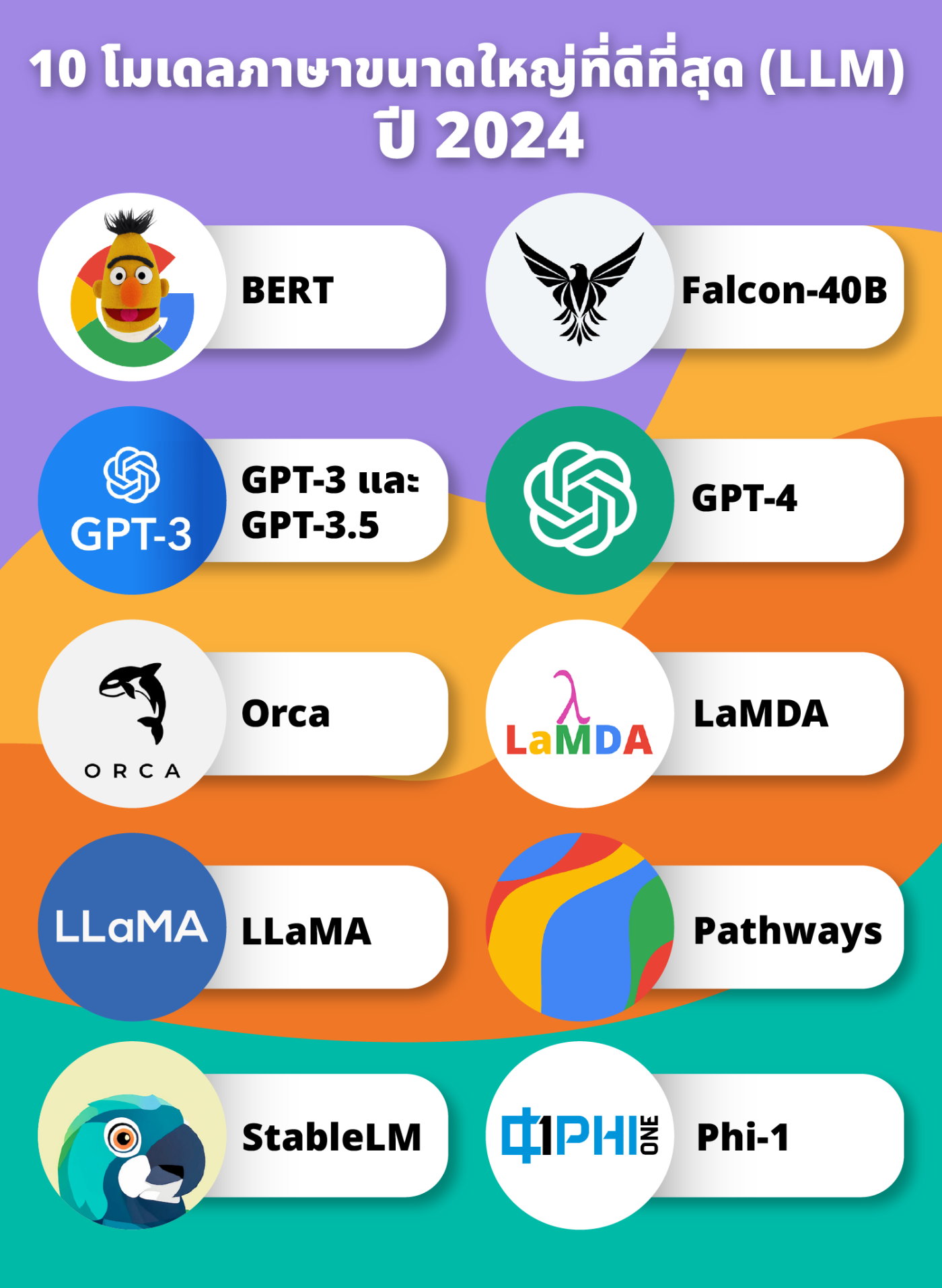

10 โมเดลภาษาขนาดใหญ่ที่ดีที่สุด (LLM) ปี 2024

2024-03-22 03:10:58

โมเดลภาษาขนาดใหญ่ (LLM) คืออัลกอริธึมการเรียนรู้เชิงลึกที่สามารถทำงาน การประมวลผลภาษาธรรมชาติ (NLP) ได้หลากหลาย โมเดลภาษาขนาดใหญ่ใช้โมเดล Transformer และได้รับการฝึกอบรมโดยใช้ชุดข้อมูลขนาดใหญ่ ดังนั้น จึงมีขนาดใหญ่ ซึ่งช่วยให้พวกเขาสามารถจดจำ แปล คาดเดา หรือสร้างข้อความหรือเนื้อหาอื่นๆ ได้ และเป็นส่วนหนึ่งของโมเดลปัญญาประดิษฐ์

โมเดลภาษาขนาดใหญ่ที่ดีที่สุดของปี 2024 พร้อมด้วย ข้อดี ข้อเสีย และการใช้งานจริง

1.BERT

เป็นโมเดลภาษาที่ Google เปิดตัวในปี 2018 โดยเริ่มแรกนำมาใช้เป็นภาษาอังกฤษในโมเดล 2 ขนาดที่ฝึกในวิกิพีเดียภาษาอังกฤษ (2,500 ล้านคำ) และ Toronto BookCorpus (800 ล้านคำ) โดยใช้ Transformer ซึ่งเป็นกลไกที่เรียนรู้ความสัมพันธ์ตามบริบทระหว่างคำต่างๆ Transformer มีสองกลไก: ตัวเข้ารหัสสำหรับการอ่านการป้อนข้อความ และตัวถอดรหัสที่สร้างการทำนายสำหรับงาน

ข้อดี

-ความแม่นยำสูงสำหรับงานประมวลผลภาษาธรรมชาติ (NLP)

-ฟรี

-ความต้องการหน่วยความจำเหลือน้อย

-เหมาะสำหรับการจำแนกประเภทงาน

-ง่ายต่อการปรับใช้และปรับแต่ง

ข้อเสีย

-ความเข้าใจบริบทที่จำกัด

-ไม่สามารถจัดการอินพุตหลายรายการได้

-ขาดการสร้างข้อความ

-การสนับสนุนแบบจำกัดสำหรับภาษาที่ไม่ใช่ภาษาอังกฤษ

-การปรับแต่งแบบละเอียดอาจใช้เวลานาน

โดยทั่วไปบริษัทต่างๆ จะใช้ BERT สำหรับแอปพลิเคชันต่อไปนี้

-การสรุปข้อความ

-ดึงข้อมูลอันทรงคุณค่าจากวรรณกรรมชีวการแพทย์มาวิจัย

-ค้นหาความสัมพันธ์คุณภาพสูงระหว่างแนวคิดทางการแพทย์

2.Falcon-40B

เป็น LLM แบบโอเพ่นซอร์สที่มีมูลค่า 4 หมื่นล้านพารามิเตอร์ ซึ่งอยู่ภายใต้ลิขสิทธิ์ Apache 2.0 มีให้เลือกสองรุ่นย่อย: Falcon-1B (หนึ่งพันล้านพารามิเตอร์) และ Falcon-7B (เจ็ดพันล้านพารามิเตอร์) ซึ่ง Falcon-40B ได้รับการฝึกอบรมเกี่ยวกับงานการสร้างแบบจำลองภาษาทั่วไป ซึ่งหมายความว่าทำงานโดยการทำนายคำถัดไป สถาปัตยกรรมของมันคล้ายกับโมเดลภาษา GPT-3

ข้อดี

-เปิดให้ใช้ในเชิงพาณิชย์และการวิจัย

-ใช้ไปป์ไลน์ที่กำหนดเองเพื่อดูแลและประมวลผลข้อมูลจากแหล่งข้อมูลออนไลน์ที่หลากหลาย เพื่อให้มั่นใจว่า LLM สามารถเข้าถึงข้อมูลที่เกี่ยวข้องได้อย่างหลากหลาย

-ข้อกำหนดในการคำนวณน้อยลง

-มอบประสบการณ์เชิงโต้ตอบและมีส่วนร่วมมากกว่าซีรีส์ GPT เนื่องจากมีการสนทนามากกว่า

ข้อเสีย

-พารามิเตอร์น้อยกว่าซีรี่ส์ GPT

-รองรับเฉพาะภาษาอังกฤษ สเปน เยอรมัน ฝรั่งเศส อิตาลี โปแลนด์ โปรตุเกส เช็ก ดัตช์ โรมาเนีย และสวีเดน

การใช้งาน

-การวิเคราะห์วรรณกรรมทางการแพทย์

-การวิเคราะห์บันทึกผู้ป่วย

-การวิเคราะห์ความรู้สึกเพื่อการตลาด

-การแปล

-แชทบอท

-การพัฒนาเกมและการเขียนเชิงสร้างสรรค์

3.GPT-3 และ GPT-3.5

เป็นโมเดลของ OpenAI ที่ีเปิดตัวในปี 2020 ผ่านการฝึกอบรมคำศัพท์หลายพันล้านคำ ทำให้คุ้นเคยกับภาษามนุษย์ เช่นเดียวกับ LLM อื่นๆ ในรายการนี้ เป็นโมเดล AI เชิงสร้างสรรค์ที่สร้างภาษาอย่างอิสระและโต้ตอบกับผู้ใช้

ข้อดี

-เพิ่มความคิดสร้างสรรค์และผลผลิต

-เวอร์ชันพื้นฐานนั้นฟรี

-คุ้มต้นทุนสำหรับการใช้งานเต็มรูปแบบหากคุณมีงานไม่มาก

-ต้องการโครงสร้างพื้นฐานขั้นต่ำ

-การฝึกอบรมพนักงานน้อยที่สุด

ข้อเสีย

-มีราคาแพงสำหรับการใช้งานสูง

-อาจเปิดเผยข้อมูลที่ละเอียดอ่อน

-ไม่ได้รับการฝึกอบรมอย่างต่อเนื่อง — แหล่งข้อมูลจะลงท้ายด้วยข้อมูลปี 2021

-ภาพหลอน (ข้อมูลเท็จที่เบี่ยงเบนไปจากตรรกะเชิงบริบทหรือข้อเท็จจริงภายนอก)

การใช้งาน

บริษัทต่างๆ ยังสามารถใช้ GPT-3 และ 3.5 สำหรับแอปพลิเคชันต่อไปนี้:

-บริการลูกค้า

-แชทบอท

-การสร้างเนื้อหา รวมถึงบล็อกโพสต์ เนื้อหาแบบยาว สคริปต์วิดีโอ YouTube สำเนาโฆษณาและการตลาด และคำอธิบายผลิตภัณฑ์

-ผู้ช่วยเสมือน

-การแปล

-การเข้ารหัส

-การสรุป

-การสร้างระดับความเสี่ยง

-การออกแบบเกมและการเขียนเชิงสร้างสรรค์

4.GPT-4

GPT-4เป็นรุ่น OpenAI GPT ที่ใหญ่ที่สุด ต่างจากรุ่นก่อนตรงที่สามารถประมวลผลและสร้างทั้งรูปภาพและภาษาได้ นอกจากนี้ยังมีข้อความระบบที่ให้ผู้ใช้ระบุงานและน้ำเสียงได้ ตั้งแต่เดือนสิงหาคม 2023 GPT-4 พร้อมใช้งานใน ChatGPT Plus ขับเคลื่อนการค้นหา Microsoft Bing และจะรวมเข้ากับผลิตภัณฑ์ Microsoft Office ในที่สุด

ข้อดี

-สามารถสร้างภาษาและรูปภาพได้

-ความคิดสร้างสรรค์ที่ได้รับการปรับปรุง รวมถึงความสามารถในการสร้างเรื่องราวที่น่าดึงดูดและสอดคล้องกัน

-คุ้มต้นทุนและปรับขนาดได้

-สามารถปรับให้เป็นแบบส่วนตัวได้

ข้อเสีย

-สามารถสร้างข้อความที่สร้างขึ้นได้อย่างสมบูรณ์

-ไม่สามารถสร้างแนวคิดใหม่ทั้งหมดหรือคาดการณ์ได้

-ต้องใช้ข้อมูลการฝึกอบรมจำนวนมากเพื่อสร้างโค้ดคุณภาพสูง ซึ่งอาจเป็นเรื่องยากสำหรับบริษัทซอฟต์แวร์ขนาดเล็ก

5.Orca

ถูกสร้างขึ้นโดย Microsoft และมีพารามิเตอร์ถึง 13 พันล้านพารามิเตอร์ โดยใช้ประโยชน์จากความสามารถของ ChatGPT และจับคู่ได้ถึง GPT-3.5 สำหรับงานส่วนใหญ่ โดยพื้นฐานแล้ว Orca เป็น GPT-4 เวอร์ชันเล็กกว่า ใช้ความช่วยเหลือของครูและการเรียนรู้แบบก้าวหน้าจาก GPT-4 เพื่อเลียนแบบการใช้เหตุผลของมนุษย์

ข้อดี

-มีประสิทธิภาพมากกว่าโมเดลโอเพ่นซอร์สอื่น

-รูปแบบการเรียนรู้แบบก้าวหน้าช่วยให้ Orca ต่อยอดความรู้ทีละน้อย

-ทำงานบนแล็ปท็อป

-ช่วยให้ทีมเรียนรู้เกี่ยวกับแนวคิดที่ซับซ้อน เช่น การใช้เหตุผลทางกฎหมายและการวางแผนทางการเงิน

ข้อเสีย

-อยู่ในระหว่างดำเนินการ การฝึกอบรม

-ต้องการทรัพยากรการประมวลผลจำนวนมาก

-Orca โดยใช้ CPU จะช้ากว่าเมื่อเทียบกับการตั้งค่าที่เร่งด้วย GPU

การใช้งาน

-สร้างสคริปต์ เนื้อหา โค้ด

-ระดมความคิดสำหรับโปรเจ็กต์

-ช่วยคอมพิวเตอร์ให้เหตุผลเกี่ยวกับหัวข้อที่ซับซ้อน เช่น กฎหมาย การวางแผนทางการเงิน และการวินิจฉัยทางการแพทย์

6.LaMDA

โมเดลภาษาสำหรับแอปพลิเคชันการสนทนา (LaMDA) คือกลุ่มของ LLM ที่สร้างโดย Google Brain ได้รับการพัฒนาและเปิดตัวครั้งแรกในชื่อ Meena ในปี 2020 Bard ซึ่งเป็นบริการแชท AI รุ่นทดลองของ Google เริ่มแรกมีพื้นฐานมาจากโมเดล LaMDA LLM โดย LaMDA จะมีการทำงานคล้ายกับ BERT และใช้โมเดลภาษาหม้อแปลงเฉพาะตัวถอดรหัสเท่านั้น ได้รับการฝึกอบรมล่วงหน้าเกี่ยวกับคลังข้อความ รวมถึงบทสนทนาและเอกสารที่ประกอบด้วยคำศัพท์ 1.56 ล้านล้านคำ

ข้อดี

-สามารถสนทนากับผู้ใช้ได้อย่างสมจริงเนื่องจากการฝึกอบรมในการสนทนา

-ดึงข้อมูลจากอินเทอร์เน็ตอย่างต่อเนื่อง

-เชี่ยวชาญในการสนทนา

ข้อเสีย

-ไม่ค่อยมีใครรู้เกี่ยวกับ LaMDA

-เฉพาะทีมและบุคคลที่ได้รับการอนุมัติเท่านั้นที่สามารถทดสอบได้

การใช้งาน

องค์กรต่างๆ สามารถใช้ LaMDA สำหรับแชทบอทสนับสนุนลูกค้า การวิจัย การระดมความคิด และการจัดระเบียบข้อมูล

7.LLaMA

โมเดลภาษาขนาดใหญ่ Meta AI (LLaMA) เป็นโมเดลภาษาที่พัฒนาโดย Meta ปัจจุบัน LLaMA เป็นโมเดลภาษาโอเพ่นซอร์สขนาดใหญ่ ซึ่งเริ่มแรกเปิดตัวให้กับนักพัฒนาและนักวิจัยที่ได้รับอนุมัติเท่านั้น รุ่น LLaMa มีหลายขนาด รวมถึงรุ่นเล็กที่ใช้พลังประมวลผลน้อยกว่า เวอร์ชันที่ใหญ่ที่สุดมีพารามิเตอร์ 65 พันล้านพารามิเตอร์

ข้อดี

-มีหลายขนาดให้เลือก

-มีประสิทธิภาพมากกว่า LLM อื่นๆ

-ใช้ทรัพยากรน้อยกว่ารุ่นอื่นๆ มากมาย

ข้อเสีย

-การปรับแต่งที่จำกัดสำหรับนักพัฒนา

-ใบอนุญาตที่ไม่ใช่เชิงพาณิชย์เท่านั้น ซึ่งหมายความว่าคุณไม่สามารถใช้กับแอปพลิเคชันเชิงพาณิชย์ เช่น การตลาดหรือการพัฒนาซอฟต์แวร์

การใช้งาน

บริษัทต่างๆ มักจะใช้ LLaMA เพื่อสร้างแชทบอท สรุปข้อความ และสร้างเนื้อหา นอกจากนี้ยังสามารถใช้เพื่อวัตถุประสงค์ในการวิจัย โดยเฉพาะอย่างยิ่งหากนักวิจัยจำเป็นต้องทดสอบและฝึกแบบจำลอง LLM ได้อย่างรวดเร็วและมีประสิทธิภาพ

8.Pathways

คือโมเดลภาษาที่ใช้หม้อแปลงพารามิเตอร์ 540 พันล้านพารามิเตอร์ที่สร้างโดย Google AI PaLM มีเวอร์ชันเล็กกว่า รวมถึงโมเดลพารามิเตอร์แปดพันล้านและ 62 พันล้าน เช่นเดียวกับโมเดลภาษาขนาดใหญ่ยอดนิยมในรายการนี้ PaLM เป็นโมเดล Transformer ที่ทำงานโดยการเรียนรู้ที่จะแสดงความสัมพันธ์ระหว่างวลีและคำในประโยค

ข้อดี

-มีจำหน่ายในขนาดที่เล็กกว่า

-รองรับมากกว่า 100 ภาษา

-ความสามารถในการสร้างโค้ดและการให้เหตุผลอันทรงพลัง

-บูรณาการระบบนิเวศของ Google ได้อย่างราบรื่น

-ผลลัพธ์ที่ควบคุมได้ — ผู้ใช้สามารถควบคุมโทนเสียง สไตล์ และผลลัพธ์ที่ต้องการของข้อความที่สร้างขึ้นได้มากขึ้น

ข้อเสีย

-มีความยั่งยืนต่อสิ่งแวดล้อมน้อยกว่ารุ่นอื่นๆ

-มีขนาดใหญ่

-ไม่เหมาะที่สุดสำหรับผู้คนและบริษัทที่ให้ความสำคัญกับประสิทธิภาพ

การใช้งาน

บริษัทต่างๆ สามารถใช้ PaLM สำหรับการเขียนโค้ด การแก้ปัญหาที่ซับซ้อน การคำนวณ และการแปล

9.StableLM

เป็นโมเดลโอเพ่นซอร์สที่ออกแบบมาสำหรับงานประมวลผลภาษาธรรมชาติต่างๆ ทุกคนสามารถใช้และแก้ไขได้โดยไม่มีข้อจำกัดใดๆ นักพัฒนาที่สนใจสามารถดาวน์โหลดได้จาก GitHub ในขนาดโมเดลพารามิเตอร์สามถึงเจ็ดพันล้าน ใช้ประโยชน์จากพลังของชุดข้อมูลโอเพ่นซอร์สล้ำสมัยห้าชุดที่สร้างขึ้นโดยเฉพาะสำหรับ LLM การสนทนา ได้แก่ Dolly, HH, Alpaca, GPT5All และ ShareGPT ด้วยเหตุนี้ StableLM จึงดีกว่าคู่แข่งในการสนทนาที่ยาวนาน

ข้อดี

-ภาษาโอเพ่นซอร์ส

-ปรับแต่งได้สูง

-มีประสิทธิภาพ

-รวมถึงข้อความเป็นรูปภาพ

-ประกอบด้วยซอฟต์แวร์รุ่นเบต้า การสาธิตสาธารณะ และการดาวน์โหลดโมเดลที่สมบูรณ์สำหรับการใช้งานภายในองค์กรหรือบนคลาวด์

ข้อเสีย

-ไม่เก่งเรื่องการเขียนเชิงสร้างสรรค์

-อาจมีอคติเนื่องจากได้รับการฝึกอบรมเกี่ยวกับชุดข้อมูลทดลอง

-ต้องใช้ความเชี่ยวชาญทางเทคนิคในการตั้งค่า

การใช้งาน

บริษัทต่างๆ มักจะใช้ StableLM ในการสร้างรูปภาพ ระดมความคิดสำหรับโปรเจกต์ต่างๆ ตั้งแต่การแสดงตลกเดี่ยว ๆ ไปจนถึงบทช่วยสอนของ YouTube การเขียนโค้ด และการจัดระเบียบงาน

10.Phi-1

รุ่นล่าสุดของ Microsoft คือPhi-1 . ด้วยพารามิเตอร์เพียง 1.3 พันล้านพารามิเตอร์ โมเดลภาษาขนาดเล็กนี้จึงมีประสิทธิภาพเหนือกว่า GPT-3.5 ใช้แหล่งข้อมูลคุณภาพสูง เช่น ชุดข้อมูล StackOverflow และ Stack เช่นเดียวกับ BERT และบริษัทอื่นๆ Phi-1 เป็นโมเดลภาษาขนาดใหญ่ที่ใช้ Transformer

ข้อดี

-ข้อมูลและการตอบกลับคุณภาพสูง

-ทรัพยากรการประมวลผลน้อยลงเนื่องจากมีพารามิเตอร์น้อยลง

-การตอบสนองที่หลากหลายและน่าดึงดูดมากกว่า GPT-4

ข้อเสีย

-เป็น LLM ใหม่และอยู่ในการดำเนินการ

-ขาดความรู้เฉพาะโดเมนเกี่ยวกับ LLM ที่ใหญ่กว่า เช่น การเขียนโค้ดด้วย API เฉพาะ

-Phi-1 ยังไม่เข้าใจข้อผิดพลาดอินพุตหรือการเปลี่ยนแปลงสไตล์ในข้อความแจ้งเสมอไป เนื่องจากมีพารามิเตอร์น้อยกว่า

การใช้งาน

บริษัทต่างๆ สามารถใช้ Phi-1 สำหรับแชทบอท การแปล การสรุป และการเขียนโค้ด

ร่วมเเสดงความคิดเห็น :

Recent post

2025-01-10 10:12:01

2024-06-10 03:19:31

2024-05-31 03:06:49

2024-05-28 03:09:25

Tagscloud

บทความอื่นๆที่น่าสนใจ

บทความที่น่าสนใจอื่นๆยังมีอีกมากลองเลืือกดูจากด้านล่างนี้ได้นะครับ

2024-06-06 01:22:15

2024-08-19 10:49:29

2023-11-23 01:30:37

2024-02-26 01:33:44

2024-01-19 10:51:24

2025-03-19 10:34:30

2023-12-12 05:05:58

2023-11-21 01:09:33

2023-11-07 09:55:34